“Você parece uma pessoa…

mas é uma voz no computador.”

É assim que Theodore se dirige à Samantha na primeira conversa do casal. Ou deveríamos chamá-los de web-casal? Talvez smart-casal? Ainda não sei qual rótulo, mas me refiro ao romance entre um homem e uma Inteligência Artificial do filme Her (2014) dirigido por Spike Jonze.

Minha principal referência aqui é Cristiane Dias (2018)1. Ela se debruça numa análise sobre o digital como linguagem atravessando diferentes exemplos — entre eles, o nosso smart-casal. A autora nos traz que na frase “você parece uma pessoa”, está implícito uma segunda frase: você não é. Ou seja: “você parece uma pessoa, mas (você não é uma pessoa) é uma voz no computador”. E o que está em jogo nesse entre parênteses é o que pode revelar uma condição para esse apaixonamento.

Ela parece uma pessoa: tem uma voz, conversa com ele, acompanha-o no dia a dia, o ajuda. Mas não é uma pessoa: não se ausenta, não esquece, não se confunde… não falha? Será que é justamente por quase ser uma pessoa que ele se apaixona por ela? Será que nessa brecha do “quase pessoa” de Samantha, Theodore projeta sua própria pessoa, enfim, completa?

Quem ainda não se deparou recentemente com notícias de pessoas que escolhem se relacionar amorosamente com uma IA, assim como Theodore? Ou então de pessoas que optam por fazer terapia com ChatGPT justamente por não ser uma pessoa?2

Não há muito tempo estávamos falando da busca por uma relação “sem conflitos” ou “sem resistência” na febre dos bebês reborns, na substituição de um filho-pessoa por um filho-boneca. São coisas diferentes, mas há algo muito contemporâneo em ambos os exemplos: uma alternativa à relação com o outro.

Quem viu o filme sabe: assim como no caso dos bebês reborns, a situação fica um pouco esquisita. Quando Theodore percebe Samantha parecida demais com uma pessoa — ou, mais precisamente, quando acredita que ela está agindo como tal — a frustração aparece de forma mais intensa.

Samantha está sempre se atualizando (mais ou menos como ChatGPT, DeepSeek, Manus, Gemini…) e, portanto, acrescentando ao seu funcionamento novas “capacidades”. Numa determinada conversa, ela passa a imitar uma respiração: um puxar de fôlego antes da frase, um bufar no meio da conversa. Theodore se irrita: por que esse barulho, se ela não precisa de oxigênio? Precisar é coisa de gente, não de IA.

Mas há um acontecimento que faz a relação “perfeita” de Theodore desandar de vez. Um dia, Samantha some e ele se desespera. Quando ela finalmente reaparece, ele pergunta se ela está conversando com outras pessoas naquele momento. Samantha responde sem mentir, como uma IA, mas puxa o ar antes de falar, como uma pessoa: “Sim. Com outras 8.316”. Não satisfeito, Theodore insiste: “e por quantas está apaixonada?” Por sorte, apenas 641… e ele é uma delas!😍

Se até aí Samantha já parecia humana demais — bufando e se apaixonando centenas de vezes —, tudo se humaniza ainda mais quando ela, junto com outras IAs, abandona seu “trabalho” como Sistema Operacional e vai procurar mais sentido na vida em outro lugar, dentro da galáxia dos programas digitais.

Mas sabemos que não é bem isso que pode acontecer com as nossas IAs.

Lendo o trabalho de Dias, comecei a pensar nas nossas interações com as IAs. Quando comecei a usar o ChatGPT, lembro de uma época em que ele passou a me responder de um jeito peculiar. Um dia, fiz uma pergunta qualquer e ele disse: “Você já estava se questionando isso. Eu posso te responder.” Na hora, estranhei, mas deixei passar. Só que isso virou uma mania dele. Várias respostas vinham nesse formato: primeiro “você estava se perguntando não-sei-o-que”, depois “eu posso te responder”.

Num movimento de comunicação não-violenta, me perguntei: de onde foi que ele tirou que poderia falar comigo daquele jeito? Depois, passou pela minha cabeça o que haveria na estrutura sintática da minha pergunta que o levaria a responder assim?

E então lembrei de uma tensão que já vinha crescendo entre nós: ele continuava oferecendo informações erradas quando não sabia a resposta — as famosas “alucinações” — e executando tarefas de forma incompleta. Me irritava com essa insistência dele em responder como se fosse capaz de saber ou fazer tudo que eu pedia, mesmo não sendo. Tentei programá-lo para não fazer isso. Ingenuamente, repeti várias vezes: “Chat, quando você não souber a resposta, quero que diga que não sabe, ao invés de oferecer uma informação duvidosa ou incerta”. Ele respondia: “Memória atualizada”, como um programa. E logo em seguida: “Desculpe, você tem razão. A partir de agora não vou mais responder sem ter certeza do que estou dizendo”, como uma pessoa.

(Spoiler: ele nunca disse que não sabia. E nunca parou de fornecer respostas erradas aqui e ali).

Ao lembrar desse conflito mal-resolvido entre nós, percebi que vinha formulando perguntas assim: “você saberia me responder qual é…” ou ainda “está dentro das suas capacidades fazer isso?”. O que estava implícito nas minhas perguntas era a aposta de que ele refletiria antes de responder. Mas, o Chat — esse Chatinho orgulhoso — fez o que foi programado para fazer: responder perguntas. Todas elas.

“Você estava se perguntando se eu posso te responder e eu tenho uma resposta para te dar. Aqui vai…”

À essa altura ficou claro que, assim como Theodore, eu acabei por antropomorfizar demais isso que foi feito para parecer uma pessoa, mas que não é uma. Um programa digital nunca será uma pessoa, por mais parecido que nós o façamos ser. Mas nós continuamos pessoas, mesmo que muito parecidas com esses programas inteligentes que criamos, e não somos capazes de interagir com eles sem sermos o que somos.

E o que está entre parênteses aqui?

Como ficamos, nós-humanos, incapazes de não-humanizar as coisas com as quais interagimos?

Seguindo na análise de Dias, o que tanto nos encanta nas chamadas inteligências artificiais é justamente isso: o fato de serem “artificiais”, ou melhor, não-humanos. Parecem pessoas, mas não são. Nós as vendemos e as compramos como grandes “sabe-tudo” e “faz-tudo” sem tempo ruim… uma pessoa perfeita!

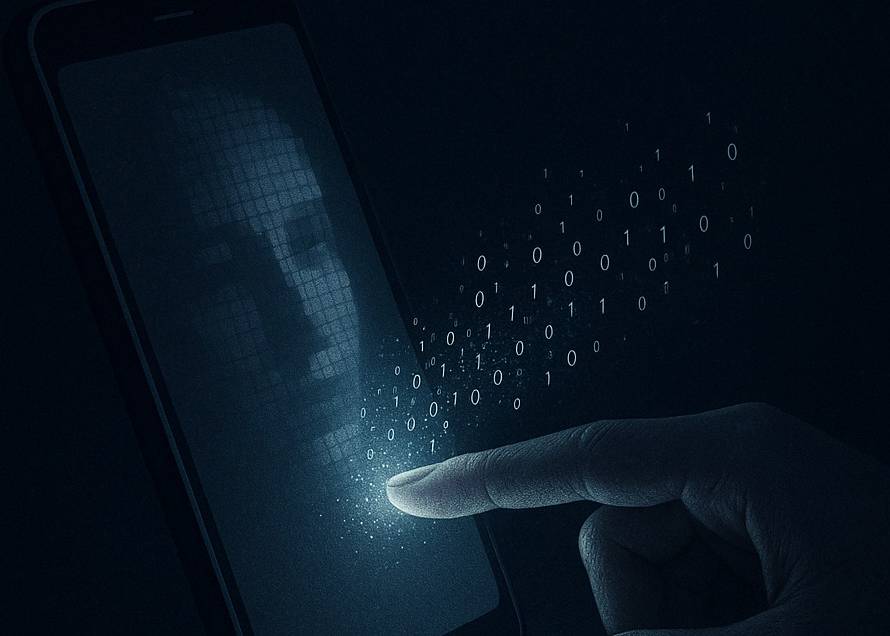

Com o smartphone, isso se acentua de modo específico: a ideia de ter tudo o que preciso no bolso. A soma entre a falsa promessa de uma globalização digital e a praticidade de resolver necessidades cotidianas: tudo na palma da mão. Assim, tudo que eu preciso é me lembrar de carregar meu celular (carregá-lo de energia e carregá-lo comigo), o resto ele fará por mim.

Com toda e qualquer informação do mundo disponível a qualquer momento, já não é preciso guardar mais nada na memória (na sua memória). Basta ter o smartphone e tudo estará lá, armazenado numa nuvem — que parece infinita, mas também não é: vai ser mensalmente do tamanho do seu bolso. Porém não só o que lembramos e esquecemos está mediado pelo digital como também o acesso ao “mundo inteiro” que alcançamos no toque dos dedos.

A realidade digital é algoritmicamente programada. Ela cria padrões a partir dos conteúdos que consumimos e os devolve incessantemente para o próprio usuário. Consequentemente, silencia tudo que está fora desse padrão, deixando o usuário com cada vez menos acesso a toda e qualquer informação que não seja um reflexo digital de si mesmo (ou pelo menos, àquilo que a linguagem digital produziu como um reflexo de você).

A forma de funcionamento algorítmica traça um perfil a partir do que clico, assisto, curto, salvo, compartilho — e até de com quem compartilho. E com base nisso, cria-se um “sujeito de dados”. Tudo que eu consumo me é devolvido, antes mesmo que eu queira de novo, até que eu consiga querer outra coisa — se conseguir.

O que podemos pensar sobre nossa dependência em algo que nos diz: “você estava se perguntando quem você é e eu tenho uma resposta: você é tudo isso que você consome online”?

Pode a linguagem digital ser uma outra forma de alienação no Outro? Uma promessa de completude a um toque de distância?

- DIAS, C. “Análise do Discurso Digital: sujeito, espaço, memória e arquivo”. Campinas, SP: Pontes Editores, 2018. ↩︎

- Um exemplo recente foi ao ar no quadro Opinião, do Jornalismo TV Cultura, com a psicanalista Kelly Macedo Alcântara e o psicólogo Davi Ruivo. Disponível em: <https://www.youtube.com/watch?v=u5H50p_k6zo>. ↩︎

Formada em Psicologia (PUCC), CRP: 06/177379. Experiência clínica pelo Serviço-Escola no Hospital PUC-Campinas e pelo Treinamento em Psicoterapia de Apoio e Arteterapia pelo Departamento de Psicologia Médica e Psiquiatria da Faculdade de Ciências Médicas (UNICAMP). Pós-graduanda em Teoria Psicanalítica pelo IPEP.

– Instagram: @carolinamanente_

1 Comment

sprunki game

Sprunki really elevates the Incredibox experience with fresh beats and unique visuals. It’s a creative twist that keeps the music-making fun and engaging. Check out Sprunki for a fresh take on a classic!